اولین بار که فیلم «ترمیناتور» را تماشا کردم حس عجیبی داشتم. در ابتدا با ربات مثبت فیلم که «آرنولد شوارتزنگر» افسانهای آن را بازی میکرد ارتباط خوبی گرفتم. ولی چند لحظه بعد به یاد ربات منفی فیلم افتادم! رباتی که صرفاً برای نابودی آموزش دیده بود و چون ربات بود، کاری جز این از دستش برنمیآمد.

حالا با داغ شدن بحث ربات های هوش مصنوعی مثل ChatGPT یا ربات جدید گوگل یعنی Google Bard ، دوباره به آن روزها رفتهام. در قرن گذشته تکنولوژی ما را به جایی رساند که انسانها با بهرهگیری از قدرت اتم، توانایی نابود کردن کل سیاره را به دست آوردند. حالا به لطف هوش مصنوعی ما با نگرانیهای جدیدی مواجه شدهایم. نگرانیهایی که از مدل زبانی گوگل یعنی LaMDA شروع شد.

اما اصلاً گوگل لامدا (LaMDA) چیست؟ آیا گوگل لامدا خودآگاه است؟ آیا رباتها قرار است با دستیابی به آگاهی و احساسات، سیاره ما را تسخیر کنند؟ آیا داستانهای علمی-تخیلی درباره آخرالزمان رباتها قرار است به واقعیت بدل شوند؟ سؤالات بحثبرانگیزی که این روزها همه جا مطرح میشود و بعضاً پاسخهای عجیبی برای آنها میشنویم…

من دراین مقاله میخواهم سیر تا پیاز هوش مصنوعی گوگل یا گوگل لامدا را بررسی کنم و در آخر نتیجه بگیرم که مدل های زبانی پیشرفته مثل LaMDA قرار است چه اتفاقاتی در زندگی ما انسان ها رقم بزنند. پس با این مقاله هیجان انگیز همراه من باشید.

مدل زبانی LaMDA چیست؟

LaMDA مخفف عبارت Language Model for Dialog Application است. یعنی یک مدل زبانی که برای کاربرد گفتگو استفاده میشود. مدل زبانی لامدا با یادگیری ماشین (Machine Learning) توسعه داده شده و به طور خاص روی خلق گفتگوی طبیعی متمرکز است.

یادگیری ماشین به رایانهها کمک میکند الگوها و روابط موجود در دادهها را کشف کنند. مثلاً میتوانید یک الگوریتم یادگیری ماشین را روی همه آثار شکسپیر آموزش دهید و سپس از آن بخواهید متون اورجینال و جدیدی تولید کند که شبیه شکسپیر باشند. اساس کار مدل زبانی LaMDA نیز به همین شکل است.

اما همانطور که «ساندرا پیچای» (مدیرعامل گوگل) در مصاحبهای با Yahoo Finance توضیح میدهد، گوگل لامدا با دیگر مدلهای زبانی کلاسیک متفاوت است. زیرا به طور خاص در زمینه دیالوگ و گفتگو آموزش دیده است.

چرا گوگل نیاز به مدل زبانی لامدا دارد؟

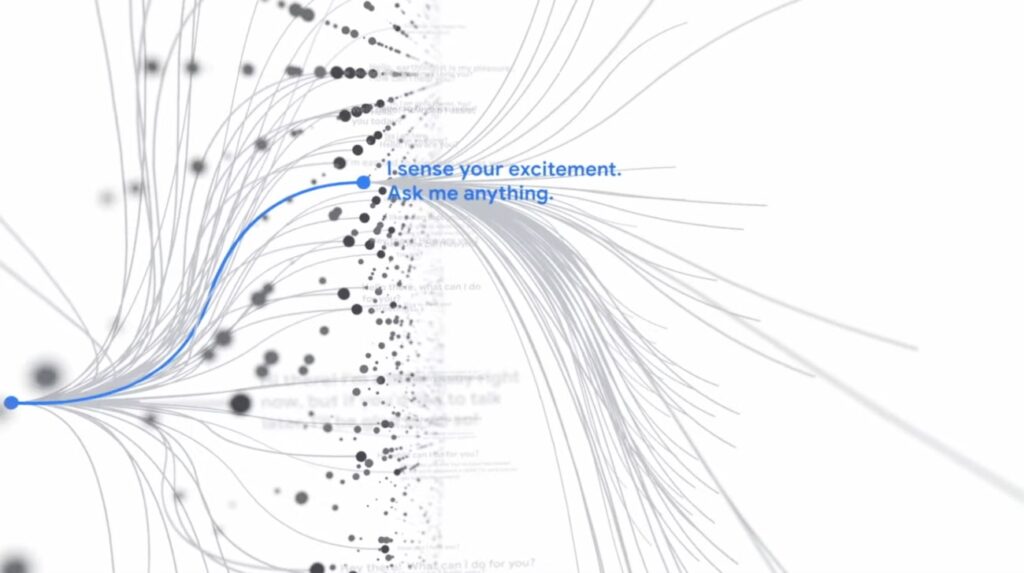

هدف از طراحی و توسعه مدل زبانی LaMDA این است که گوگل بتواند با کاربران خود «گفتگوی انسانی با پایان باز» (Human-Like Open-Ended Dialogue) داشته باشد. یعنی گفتگویی طبیعی که بعضاً بتواند کاربر را شگفتزده کند و به همین زودیها هم تمام نشود.

فعلاً ما برای جستجو در گوگل باید نوعی لحن رسمی یا رباتیک داشته باشیم. اصطلاحاً باکس جستجوی گوگل نمیتواند بعضی عبارات انسانی را هندل کند. اما با توسعه مدل زبانی لامدا LaMDA افرادی که از محصولات شرکت گوگل چیزهای خاصی میخواهند، نیازی به تغییر نحوه تفکر یا صحبت خود ندارند. آنها میتوانند با سیستم کامپیوتری به همان شکلی که با شخص دیگری تعامل دارند، تعامل داشته باشند.

هوش LaMDA چطور آموزش داده شده است؟

طبق توضیحات شرکت گوگل، لامدا دارای یک فرآیند آموزشی دو مرحلهای بوده که با نامهای «پیشآموزش» (Pre-training) و «تنظیم دقیق» (Fine-tuning) معرفی شدهاند. جالب اینجاست که در مجموع گوگل لامدا بر روی 1.56 تریلیون کلمه و 137 میلیارد پارامتر آموزش داده شده است.

1) مرحله پیشآموزش

برای مرحله پیشآموزش، تیم گوگل مجموعه دادهای متشکل از 1.56 تریلیون کلمه را از صدها سند عمومی وب تولید کرد. سپس این مجموعه داده اصطلاحاً Tokenized شد. یعنی برای ساختن جملهها به رشتهای از کاراکترها تبدیل شد.

در طول مرحله پیشآموزش، مدل برای پیشبینی بخش بعدی مکالمه بر اساس نشانههای قبلی، از استراتژی «موازیسازی» (Parallelization) عمومی و مقیاسپذیر استفاده میکند.

2) مرحله تنظیم دقیق

بعد از پیشآموزش، لامدا برای انجام وظایف تولید (Generation) و طبقهبندی (Classification) وارد مرحله تنظیم دقیق میشود. بخش مولّد این مدل زبانی که قسمت بعدی گفتگو را پیشبینی میکند، بر اساس مکالمههای قبلی چندین پاسخ مرتبط ایجاد میکند.

سپس بخش طبقهبندی LaMDA به هر پاسخ احتمالی با توجه به پارامترهای «ایمنی» و «کیفیت» یک امتیاز میدهد و بهترین پاسخ را پیشبینی میکنند. همزمان که مکالمه ادامه پیدا میکند، هر پاسخی که امتیاز پایینی داشته باشد، قبل از انتخاب پاسخ با امتیاز بالا فیلتر شده و حذف میشود. هدف از این مرحله این است که مرتبطترین، باکیفیتترین و در نهایت ایمنترین پاسخ به کاربر داده شود.

گوگل لامدا دقیقاً چقدر هیجانانگیز است؟

این سؤال در نگاه اول کمی عجیب به نظر میرسد؛ اما بیشتر افرادی که در فضای اینترنت به دنبال یافتن اطلاعاتی درباره گوگل لامدا هستند، میخواهند بدانند این مدل زبانی چقدر باید آنها را هیجانزده کند؟

هنوز فرزند ارشد مدل زبانی LaMDA یعنی Apprentice Bard رسماً عرضه نشده تا بتوانیم در مورد این مدل زبانی دقیقتر صحبت کنیم. با این حال، به نظرم خیلی نباید هیجانزده شویم. چرا؟ چون داستان همراه شدن «پیچیدگی» و «سادگی» اینجا هم صدق میکند.

بگذارید یک مثال بزنم. وقتی ما در حال رانندگی با ماشین هستیم، توجهی به سیستم پیچیدۀ ماشین خود نداریم. حواسمان نیست چند جزء مختلف در تلاشاند تا عمل «رانندگی» و «جلو رفتن ماشین» اتفاق بیفتد. لبخند میزنیم و از رانندگی لذت میبریم. حالا اگر خدایی نکرده مشکلی برای ماشین پیش بیاید، تازه متوجه قطعاتش میشویم. این ذات ماشینیِ ماشینمان تازه خودش را نشان میدهد!

در مورد لامدا نیز این مسئله صدق میکند. درست است که این مدل زبانی میتواند جواب ما را مثل آدم بدهد (!) اما تمام مدلهای یادگیری ماشین در واقع ترکیبی از صدها مدل پیچیده ریاضی و آماری هستند. آنها الگوریتمهای خاص خودشان را دارند و هرچقدر هم پیشرفته باشند، به احتمال زیاد بعضی وقتها خطا خواهند داشت.

الگوریتمهای هوش مصنوعی تا وقتی بینقص عمل میکنند که دادههای باکیفیت و کافی به آنها بدهید. در این صورت، این الگوریتمها در انجام کارهایی که تنها انسان یا سایر هوشهای طبیعی قادر به انجام آنها بودهاند، به طرز شگفتآوری عالی عمل میکنند. اما وقتی سعی کنید آنها را به بازی بگیرید، تازه متوجه مصنوعی بودنشان میشوید.

اگر این «هوش» واقعاً «مصنوعی» است، پس ماجرای کارمند گوگل چه بود؟

اگر ماجرای آقای بلیک لمیون درباره افشاگری اش در مورد هوش مصنوعی LaMDA را نخوانده اید، توصیه میکنم اول این خبر را در سایت دیجیاتو بخوانید تا در داستان قرار بگیرید.

آقای «بلیک لموین» یکی از مهندسین ارشد گوگل برای اینکه ثابت کند LaMDA ممکن است احساس داشته باشد، یک مصاحبه از خودش و این مدل زبانی منتشر کرد. لموین ماهها با این نرمافزار گفتگو کرده بود. تمام این ماهها صرف بازجویی و پرسیدن سؤالات پیچیده از هوش مصنوعی لامدا شده بود و حالا از نظر لیمون یک جای کار میلنگید.

او حس میکرد پاسخهای پیچیده و مناسب لامدا از یک موجود باشعور یا دارای ادراک (Sentient) میآید!

هرکسی که میخواهد بفهمد چرا لموین چنین حسی داشت، میتواند پاسخهای LaMDA را در اینجا بخواند. این پاسخها به قدری انسانیاند که یادآور دستیار شخصی خیالی در فیلم Her هستند. فیلمی که در آن انسان با هوش مصنوعی محاورهای (Conversational AI) یک رابطۀ عاطفی جدی برقرار میکند.

جدای از اینکه ادعاهای لموین درباره خودآگاه بودن یا ادراک داشتن این مدل درست است یا نه، باید توجه داشته باشیم که هدف گوگل از طراحی LaMDA همین گفتوگوهای طبیعی و قابل باور بوده است.

حالا اگر از این منظر به ماجرا نگاه کنیم، نگرانی لموین نشان میدهد گوگل در ایجاد گفتوگوهای باورپذیر به موفقیت چشمگیری دست یافته است. اگر یک سیستم هوش مصنوعی بتواند انسان را متقاعد کند هوشیار است، یعنی به خوبی طراحی شده و به هدف نهاییاش نزدیک است.

با این حال، همانطور که بالاتر گفتیم، ادعاهای مربوط به خودآگاه بودن این سیستم واقعاً قابل آزمایش نیستند. چون قبل از همه چیز ما داریم در مورد یک سیستم مصنوعی صحبت میکنیم. حتی اگر این را نادیده بگیریم، خودآگاه بودن این مدل به دلایل علمی و فلسفی قابل قبول نیستند. برای درک این موضوع، باید به طور خلاصه به معنای Sentience (یا ادراک) نگاه کنیم.

جدا از جنجالهای رسانهای، قضیۀ خودآگاهی لامدا چیست؟

کلمه Sentience در معنای تحتاللفظی خود به معنای «دریافت»، «ادراک»، «حساسیت فکری»، «آگاهی» و «هوشیاری جهتدار» است. همۀ اینها یعنی موجود یا سیستمی که Sentient است، ظرفیت احساس کردن و درک کردن را دارد.

البته باید بگویم اینجا گرفتار شدن در معناشناسی و بحثهای لغوی خطرناک و گیجکننده است. زیرا به احتمال زیاد وقتی لموین از کلمه Sentience استفاده میکند، خواسته به شکل یکجا به مفاهیم متمایزی مانند «عقل» (Sapience)، «هوش» (Intelligence) و «آگاهی» (Consciousness) اشاره کند.

بنابراین بهتر است برای پیشبرد بحثمان، یک تفسیر قراردادی از ماجرای لموین داشته باشیم که تمام واژهها و مفاهیم بالا را شامل شود: او فکر میکرده لامدا سیستمی خودآگاه (Self-Aware) است. سیستمی که قادر است مثل ما در لحظه تجربۀ ذهنی داشته باشد.

(البته لموین در یک مصاحبهای دیگر عنوان کرده که LaMDA میتواند «بخواهد» و «باور کند»! این یعنی ما با چیز خطرناکتری طرفیم…!)

وقتی هوش مصنوعی مثل هوش طبیعی عمل میکند…

کمی بالاتر گفتم آگاهی انسان از تعامل میلیونها سیستم عصبی حاصل میشود. همین امر در مورد یک مدل هوش مصنوعی پیچیده مثل LaMDA گوگل هم صدق میکند. این مدل از تعداد زیادی مدلهای یادگیری ماشین سادهتر تشکیل شده که همدیگر را برای ایجاد محصول نهایی تکمیل میکنند.

پیچیدگی ناشی از تعامل سیستمهای سادهتر موضوعی است که اغلب در دنیای هوش مصنوعی با آن مواجه میشدیم، اما اگر دقت کنیم، هوش طبیعی نیز دقیقاً به همین شکل عمل میکند. خب، اگر ساز و کار دقیقاً به یک شکل است، چرا نتایج به یک شکل نباشد؟!

کمی بحث را ترسناک کنیم؟!

تا اینجا گفتم دانش ما انسانها درباره آگاهی و ادراک اندک است و حتی اگر روزی گوگل لامدا خودآگاه هم شود، شاید ما بهسختی بتوانیم این را تشخیص دهیم. بحث خودآگاهی هنوز آنقدر پیچیده است که حتی اگر ما با یک موجود خودآگاه مواجه شویم، سخت میتوانیم آن را تشخیص دهیم.

از نظر فلسفی، شما نمیدانید هر یک از افرادی که با آنها در تعامل هستید واقعاً دارای آگاهی و ادراک هستند یا خیر. این تئوری در فلسفۀ کلاسیک با نام «مسئله زامبی فلسفی» (Philosophical Zombie Problem) مشهور است. این تئوری یک سری موجودات فرضی را در نظر میگیرد که با انسان مو نمیزنند، اما در حقیقت ممکن است انسان نباشند یا فاقد هر نوع تجربۀ آگاهانه باشند.

اگر بخواهیم واقعگرا باشیم، باید تأثیر رسانه را نیز در نظر بگیریم. ما انسانهای عادی فقط چیزهایی را میدانیم و میبینیم که در رسانه وجود دارد. شاید در یکی از مؤسسات سرّی دنیا هوش مصنوعی خودآگاه وجود داشته باشد و ما از آن خبر نداشته باشیم!

بنابراین در رابطه با خودآگاهی گوگل لامدا باید کمی عقبتر بیاییم و مسائل را واقعبینانهتر و عمیقتر ببینیم. اینطوری هم کمتر درگیر جوهای رسانهای میشویم، هم میفهمیم که به غیر از گوگل لامدا هنوز خیلی چیزها هستند که جای نگرانی و کنجکاوی دارند.

گوگل لامدا فعلاً یک مقلّد است؛ البته فقط فعلاً…!

ما نمیدانیم آستانۀ ظهور احساسات چیست. این یعنی در تحقیق و توسعه مدلهایی مانند گوگل لامدا ما در حال بازی با دم شیر هستیم!

این احتمال وجود دارد که وقتی ترکیب مناسبی از دادهها و زیرمجموعههای ساختاری کنار هم قرار بگیرند، ناگهان هوش مصنوعی خودآگاه شود و موجودی مدّعی و قلدر، دارای قابلیت تصمیمگیری خلق شود.

با این حال، «آلن تورینگ» ریاضیدان و دانشمند علوم کامپیوتر در این باره جملۀ جالبی دارد که میگوید:

مهم نیست اگر هوش مصنوعی «واقعاً» فکر و احساس کند. در نهایت آنچه مهم است، این است که هوش مصنوعی میتواند «ظاهرِ» تفکر و احساس را به خوبی تقلید کند. تا این حد که ما نتوانیم تفاوت را تشخیص دهیم.

چشمانداز AI در آینده؛ آیا هوش مصنوعی هوشیار خواهد شد؟!

بعد از این بحثهای نفسگیر و بعضاً ترسناک، هنوز این سؤال مطرح است که چه زمانی هوش مصنوعی خودآگاه میشود؟ این سؤال کاملاً منطقی و بهجاست.

هوش مصنوعی در ابتدا به عنوان یک نسخه کامپیوتری از مغز انسان اختراع شد. مغز انسان هم تا زمانی که زنده است، تمایل دارد دریافت و ادراک داشته باشد. بنابراین پرسیدن این سؤال که «آیا هوش مصنوعی ممکن است هوشیار شود» و «چه زمانی این اتفاق میافتد» کاملاً منطقی است.

سالهاست که این سؤال بین روانشناسان، عصبشناسان، دانشمندان علوم کامپیوتر، دانشمندان علوم شناختی، فلاسفه و حتی سیاسیون مطرح است! پاسخ آن هم خیلی کوتاه این است: «ما نمیدانیم.»

آنچه میتوان با قطعیت درباره آن حرف زد، این است که هوش مصنوعی مواهب و عواقب عظیمی برای کل دنیا خواهد داشت. اگر هوش مصنوعی مثل لامدا گوگل ناگهان طبق ضوابط و اصول خودش عمل کند، ما قرار است چگونه با آن برخورد کنیم؟ اگر کارهای مجرمانه انجام داد چطور؟

بدون شک نمیتوان آن را مجازات یا جریمه کرد؛ چون در قالب یک بدن جسمانی زندگی نمیکند و برای زنده ماندن به پول و غذا نیاز ندارد. اگر هوش مصنوعی افسارگسیخته تصمیم بگیرد نیمی از جمعیت انسانهای روی زمین را به عنوان برده خود انتخاب کند، استراتژی ما چه خواهد بود؟

اینها سؤالاتی هستند که در حال حاضر در جهان مطرحاند و موردبحث قرار دارند. هیچکدام هم پاسخ دقیقی ندارند. بنابراین شما آزادید درباره آنها تحقیق کنید و حتی داستانهای علمی تخیلی خاص خودتان را در این باره بسازید!

فعلاً نگرانیهای بزرگتری وجود دارد

در حال حاضر، اشتباه گرفتن گوگل لامدا با یک هیولای دیجیتال، آسیب بیشتری نسبت به نسخۀ واقعی و فعلی آن دارد. چتباتهایی مثل ChatGPT یا بهزودی Apprentice Bard آنقدر متقاعدکننده هستند که میتوانند برای سرقت ادبی، کلاهبرداری، استراق سمع، انتشار اطلاعات خصوصی افراد، انتشار اطلاعات نادرست و اخاذی استفاده شوند.

فعلاً اینها ممکن است جامعۀ انسانی را تضعیف کند، نه ترس از آیندهای نامعلوم!

وظیفه ما در حال حاضر این است که احتمال بروز چنین خطراتی را کمتر کنیم. به جای فکر به احتمالات، باید مطمئن شویم مردم ارزش واقعی دستیارهای هوش مصنوعی را بفهمند و از آنها بهدرستی استفاده کنند.

فعلاً مردم نباید درگیر جوهای رسانهای شوند و حس کنند با یک موجود خودآگاه صحبت میکنند. مطمئناً افرادی هستند که تحت تأثیر این بحثهای خیالی، دچار اضطراب، وسواس و توهم خواهند شد. در حال حاضر این بحثها مهمتر است.

و اما کلام آخر …

این سؤال که هوش مصنوعی گوگل یعینی گوگل لامدا چیست و چرا باید نگران آن باشیم، ما را به هزارتویی وارد میکند که بیرون آمدن از آن به این راحتیها نیست. همانطور که دیدیم این سؤال، مباحث عمیقتری را به دنبال دارد که ما را به عمیقترین سیاهچالههای ناآگاهی انسان میبرد.

با این حال، جدای از بحثهای پیچیده، آنچه سعی در بیان آن داشتم این بود که الگوریتمهای سازندۀ گوگل لامدا در بهترین حالت، نسخه بسیار ساده شدهای از مغز انسان هستند. آیا چنین مدلهای سادهای میتوانند ادراک پیدا کنند؟ باید منتظر ماند و دید. فعلاً نگرانیهای بزرگتری وجود دارد.

سوالات متداول

هوش مصنوعی LaMDA خانوادهای از مدلهای زبان محاورهای است که توسط شرکت گوگل توسعه یافته است. در ژوئن 2022 زمانی که «بلیک لموین» یکی از مهندسان ارشد گوگل ادعا کرد چتبات گوگل هوشیار شده است، لامدا توجهات زیادی را به خود جلب کرد. گوگل در فوریۀ 2023 برای رقابت با ChatGPT دستیار جدید خود یعنی Bard را معرفی کرد. یک ربات هوش مصنوعی که توسط مدل زبانی LaMDA پشتیبانی میشود.

اولاً جامعه علمی تا حد زیادی ادعاهای لموین را رد کرده است. گوگل لامدا آگاه، دارای ادراک و دارای «خود» نیست. دوماً این ایده به هیچ وجه جدید نیست که حالا بخواهیم بزرگش کنیم و نگرانش باشیم. ایدۀ خودآگاه شدن هوش مصنوعی از دهه 1960 مطرح بوده و هنوز مثل یک راز باقی مانده است.

هیچ دیدگاهی نوشته نشده است.